M4L.RhythmVAE for Ableton Live: ミュージシャンのためのAIリズム生成モデル

一般のミュージシャンが、AIを自分の音楽制作過程に組み入れるためには、AIシステムはどうあるべきか? 企業が作ったお仕着せの音楽生成システムを使うだけで良いのか?

背景

AIを用いた音楽制作のためのツールが少しずつ増えてくる中で、以下のような疑問を抱くようになった。

どこまでがツールに「作らされている」曲で、どこからがアーティスト、ミュージシャンである自分が作った曲なのか。

GoogleやAmazonといった大企業が作ったAIツールの利用は、ユーザ(アーティスト)の創造性を高めることに寄与するのか、はたまた創作物の均一化につながるのか。

こうした疑問に答えるため、本研究では、ユーザである一般的なミュージシャンが自分自身でAIのモデルを学習し、すぐに創作に使える音楽生成ツールの構築を目指した。特にリズムパターンに着目し、ユーザが集めたMIDIデータを一般的な音楽制作ソフトウェア(DAW)上で学習する仕組みを構築した。

テクノロジー

深層学習モデルとしては、Variational Autoencoder(VAE)を採用。学習を高速化し少量の学習データでも学習が行えるように、シンプルなFeedforward Layerのみでモデルを構築した。またソフトウェア上で潜在ベクトルを入力して、リアルタイムにリズムを生成するために、潜在ベクトルは二次元とした。

VAEの学習時

学習済みモデルを用いた生成

アプリケーション

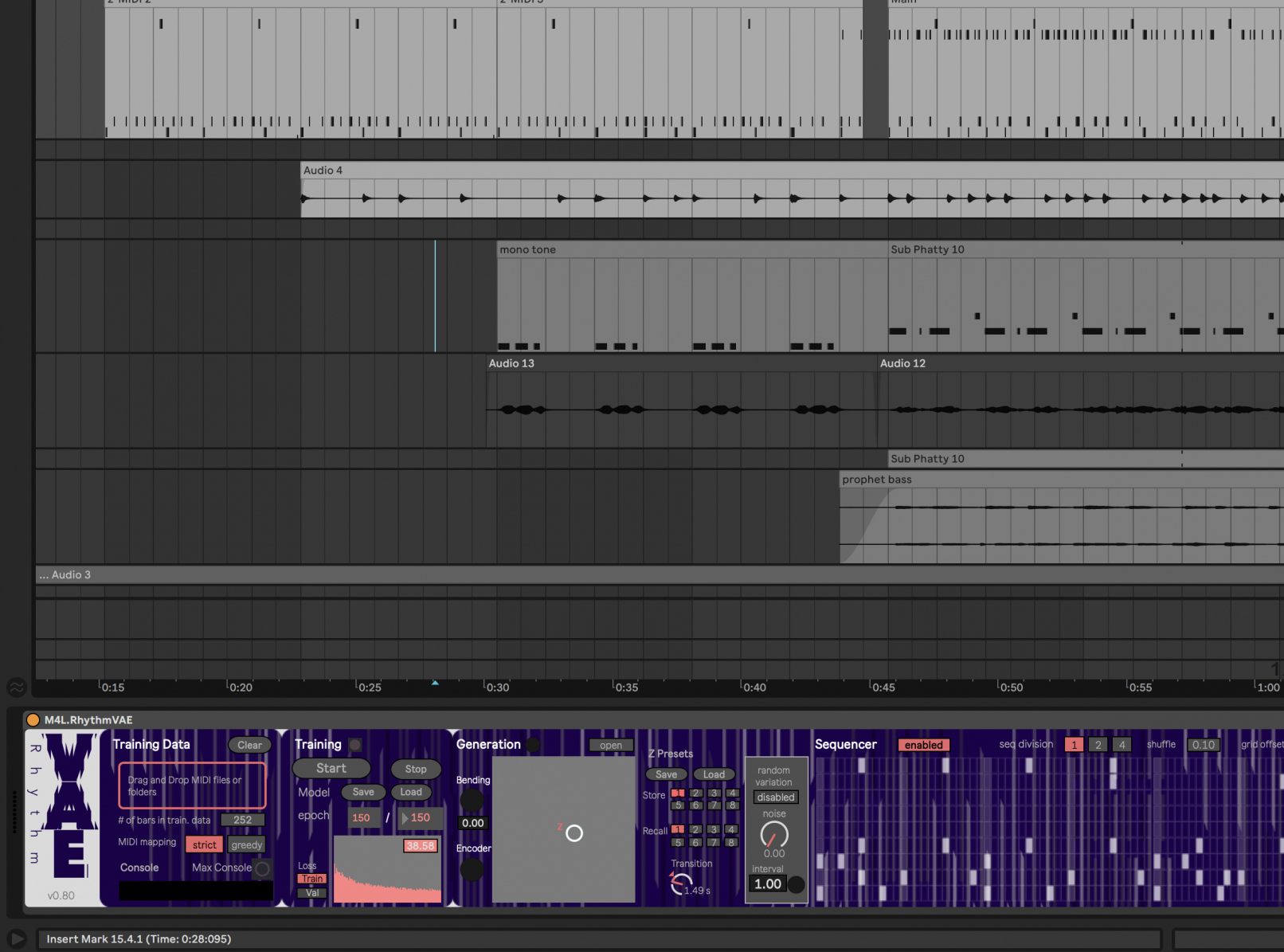

本研究では、音楽制作ソフトウェアとしてAbleton Liveを想定。学習と生成の仕組みを、Ableton Live Max for Liveデバイスとしてパッケージ化した。

VAEの学習は、リズムを含むMIDIデータをドラッグ&ドロップするのみ。学習後はオートメーションの機能を用いてVAEの潜在空間内を移動することで、ダイナミックに変化するリズムが生成される。

従来複雑な手順が必要だった音楽生成モデルの学習を一つのプラグインとしてまとめることで、一般的な音楽制作フローへの組み込みが可能になった。AIを用いた音楽制作の民主化を目指した。